¿Por qué los tribunales necesitan una ‘IA explicable’ cuando los autos sin conductor chocan?

mayo 30, 2022

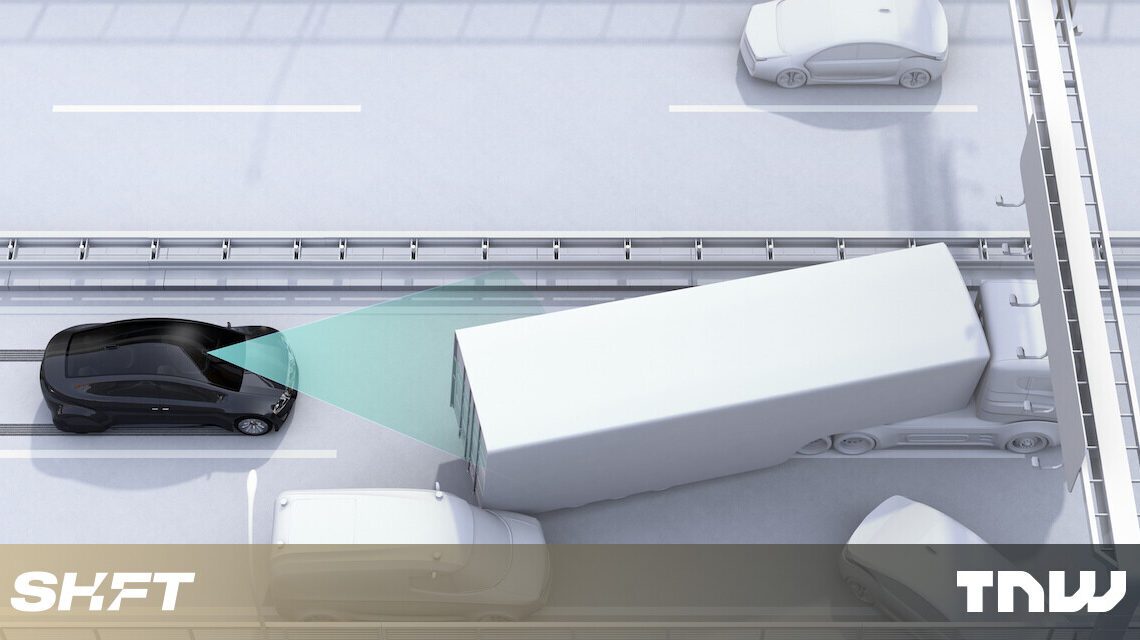

El primer accidente grave que involucró a un automóvil autónomo en Australia ocurrió en marzo de este año. Un peatón sufrió lesiones que amenazaron su vida cuando fue golpeado por un Tesla Model 3, que según el conductor estaba en modo de “piloto automático”.

En los Estados Unidos, el regulador de seguridad vial está investigando una serie de accidentes en los que los Tesla con piloto automático embistieron a los vehículos de primeros auxilios con luces intermitentes durante las paradas de tráfico.

NBC/YouTube

Los procesos de toma de decisiones de los automóviles que se conducen solos suelen ser opacos e impredecibles (incluso para sus fabricantes), por lo que puede ser difícil determinar quién debe ser responsable de incidentes como estos. Sin embargo, el creciente campo de la «IA explicable» puede ayudar a proporcionar respuestas.

¿Quién es responsable en caso de accidente de coche autónomo?

Aunque los coches autónomos son nuevos, siguen siendo máquinas fabricadas y vendidas por fabricantes. Cuando causan daños, debemos preguntarnos si el fabricante (o desarrollador de software) ha cumplido con sus responsabilidades de seguridad.

La ley de negligencia moderna proviene del famoso caso Donoghue v. Stevenson, donde una mujer descubrió un caracol podrido en su botella de cerveza de jengibre. Se consideró negligente al fabricante, no porque se suponía que debía predecir o controlar directamente el comportamiento del caracol, sino porque su proceso de embotellado no era seguro.

Según esta lógica, es posible que los fabricantes y desarrolladores de sistemas basados en IA, como los automóviles autónomos, no puedan predecir y controlar todo lo que hace el sistema de «conducción autónoma», pero pueden tomar medidas para reducir los riesgos. Si sus prácticas de gestión de riesgos, pruebas, auditoría y seguimiento no son lo suficientemente buenas, deben rendir cuentas.

¿Qué es una gestión de riesgos suficiente?

La pregunta difícil será «¿Cuánta atención y cuánta gestión de riesgos es suficiente?» En software complejo, es imposible probar cada error por adelantado. ¿Cómo sabrán los desarrolladores y fabricantes cuándo detenerse?

Afortunadamente, los tribunales, los reguladores y los organismos de estándares técnicos tienen experiencia en el establecimiento de estándares de atención y responsabilidad para actividades riesgosas pero que valen la pena.

Los estándares podrían ser muy exigentes, como el borrador de la regulación de IA de la Unión Europea, que requiere que los riesgos se reduzcan «en la medida de lo posible», sin tener en cuenta el costo. O pueden parecerse más a la ley de negligencia de Australia, que permite una gestión menos estricta para riesgos menos probables o menos graves, o donde la gestión de riesgos reduciría el beneficio general de la actividad riesgosa.

Los casos legales se complicarán por la opacidad de la IA

Una vez que tenemos un estándar claro para el riesgo, necesitamos una forma de hacerlo cumplir. Un enfoque podría ser otorgar a un regulador el poder de imponer sanciones (como lo hace la ACCC en casos de competencia, por ejemplo).

Las personas perjudicadas por los sistemas de IA también deberían poder emprender acciones legales. En los casos que involucren automóviles autónomos, las demandas contra los fabricantes serán particularmente importantes.

Sin embargo, para que tales enjuiciamientos sean efectivos, los tribunales deberán comprender en detalle los procesos y los parámetros técnicos de los sistemas de IA.

Los fabricantes a menudo prefieren no revelar estos detalles por motivos comerciales. Pero los tribunales ya cuentan con procedimientos para equilibrar los intereses comerciales con una cantidad apropiada de divulgación para facilitar el litigio.

Puede surgir un desafío mayor cuando los propios sistemas de IA son «cajas negras» opacas. Por ejemplo, la función de piloto automático de Tesla se basa en «redes neuronales profundas», un tipo popular de sistema de inteligencia artificial en el que incluso los desarrolladores nunca pueden estar seguros de cómo o por qué llegan a un resultado dado.

¿IA explicable al rescate?

Abrir la caja negra de los sistemas modernos de IA está en el centro de una nueva ola de académicos de ciencias de la computación y humanidades: el llamado movimiento de «IA explicable».

El objetivo es ayudar a los desarrolladores y usuarios finales a comprender cómo los sistemas de IA toman decisiones, ya sea modificando la forma en que se construyen los sistemas o generando explicaciones después del hecho.

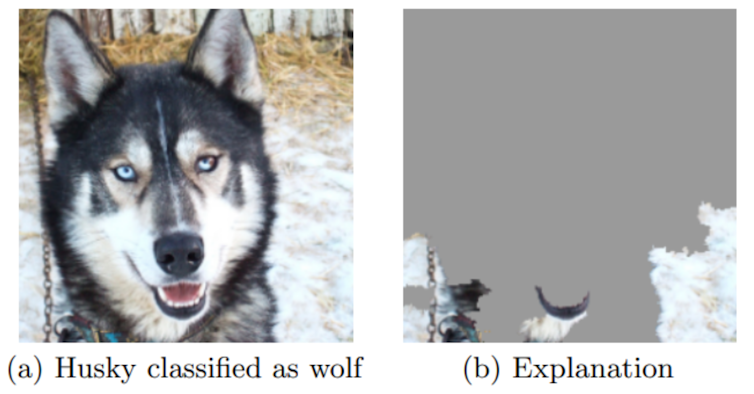

En un ejemplo clásico, un sistema de IA clasifica por error una imagen de un husky como un lobo. Un método de «IA explicable» revela el sistema centrado en la nieve en el fondo de la imagen, en lugar del animal en primer plano.

La forma en que esto podría usarse en una demanda dependerá de una variedad de factores, incluida la tecnología de IA específica y el daño causado. Una de las principales preocupaciones será el grado de acceso que tenga el perjudicado al sistema de IA.

El caso Trivago

Nuestra nueva investigación que analiza un importante caso judicial reciente en Australia proporciona una visión alentadora de cómo podría ser.

En abril de 2022, el Tribunal Federal multó a la empresa mundial de reservas de hoteles Trivago con 44,7 millones de dólares por engañar a los clientes sobre las tarifas de las habitaciones de hotel en su sitio web y en la publicidad televisiva, tras un caso presentado por el regulador de la competencia ACCC. Una pregunta crítica fue cómo el complejo algoritmo de clasificación de Trivago eligió la oferta mejor clasificada para habitaciones de hotel.

El Tribunal Federal estableció reglas para el descubrimiento de pruebas con garantías para proteger la propiedad intelectual de Trivago, y la ACCC y Trivago llamaron a testigos expertos para que proporcionaran pruebas que explicaran cómo funciona el sistema de IA de Trivago.

Incluso sin acceso completo al sistema de Trivago, el testigo experto de la ACCC pudo producir pruebas convincentes de que el comportamiento del sistema no era coherente con la afirmación de Trivago de ofrecer a los clientes el «mejor precio».

Esto muestra cómo los expertos técnicos y los abogados pueden superar juntos la opacidad de la IA en los casos judiciales. Sin embargo, el proceso requiere una estrecha colaboración y una profunda experiencia técnica, y probablemente será costoso.

Los reguladores pueden tomar medidas ahora para simplificar las cosas en el futuro, como exigir a las empresas de inteligencia artificial que documenten adecuadamente sus sistemas.

El camino por delante

Los vehículos con diversos grados de automatización son cada vez más comunes, y se están probando taxis y autobuses totalmente autónomos en Australia y en el extranjero.

Mantener nuestras carreteras lo más seguras posible requerirá una estrecha colaboración entre la inteligencia artificial y los expertos legales, y los reguladores, fabricantes, aseguradores y usuarios tendrán un papel que desempeñar.![]()

Este artículo de Aaron J. Snoswell, becario postdoctoral, derecho computacional y responsabilidad de IA, Universidad Tecnológica de Queensland; Henry Fraser, investigador en derecho, responsabilidad y ciencia de datos, Universidad Tecnológica de Queensland, y Rhyle Simcock, candidato a doctorado, Universidad Tecnológica de Queensland se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original.